克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

对于ChatGPT的工作原理,一个常见的解释是根据统计学规律预测下一个词。

但最近一位叫Jacob Bayless的工程师用数学方法得出惊人结论:

若是如此,所需的信息量足以让整个宇宙都坍塌成黑洞。

这一数据量是50000^8000,根据贝肯斯坦上限(Bekenstein bound)原理,如果把这些信息分配到空间当中,所需要的信息密度已经远超宇宙能承受的最大值。

而这仅仅是把数据存储起来的消耗,更不必说还要进行运算了。

这对过去的语言模型,或许确实成立。

比如曾经流行的n-gram算法。

比如当我们在搜索引擎中进行搜索时,出现的联想词就能用此方法实现。

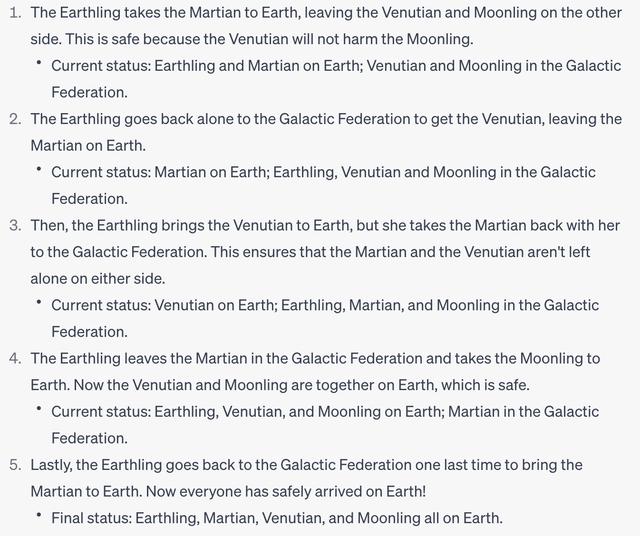

替换的目的是因为互联网上不太可能出现类似语料,可以判断大语言模型是不是真的掌握了通用方法。

如果GPT不是“随机鹦鹉”,那么它至少不会犯下只有“随机鹦鹉”才会犯的错误。

GPT-4针对替换后的问题给出了正确的回答,GPT-3.5则没有。

这个测试只是在一台笔记本电脑、算力非常有限的GPU上进行的。

更不必说GPT-4了。

参考链接:https://jbconsulting.substack.com/p/its-not-just-statistics-gpt-4-does

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

相关文章

猜你喜欢